Google Stitch

Google Stitchは、ブラウザベースのAIデザインツールで、テキストプロンプトやスケッチを多様なUIデザインと動作するHTML/CSSコードに変換します。Gemini 2.5モデルを搭載し、Figmaへのエクスポート、2つのデザインモード、月間無料利用をサポートしており、迅速なUIプロトタイピングを求めるデザイナーや開発者に最適です。

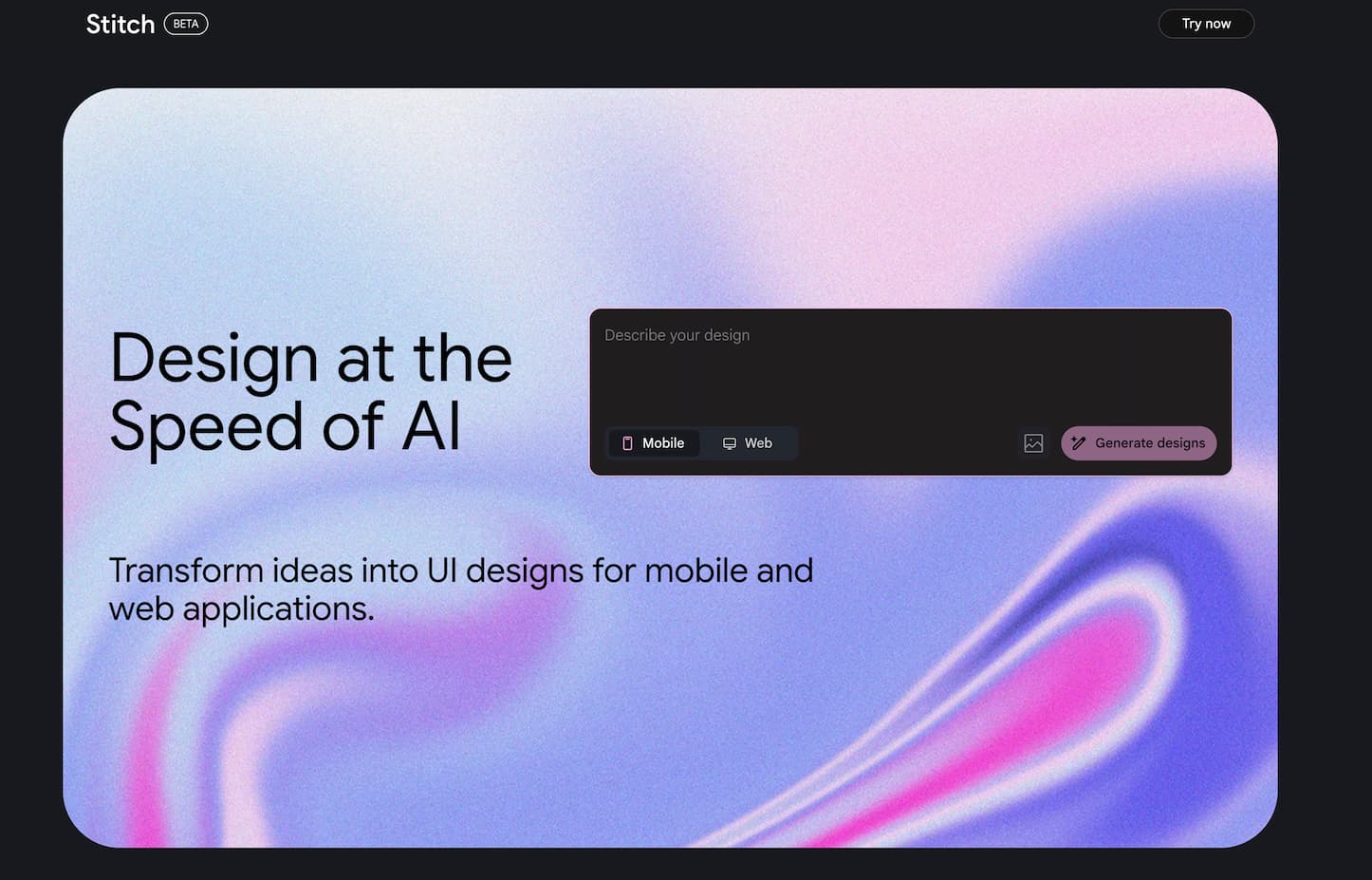

ウェブサイトプレビュー

詳細な説明

Google Stitch – AIで強化されたUIデザイン&フロントエンドコードジェネレーター

Google Stitchとは?

Google Stitchは、Google Labsから提供されるAIツールで、Google I/O 2025(5月20日)で正式に発表されました。これは、平易な英語の説明やアップロードされたスケッチを、洗練されたユーザーインターフェース(UI)デザインと、ウェブおよびモバイルアプリ用の対応するHTML/CSSコードに変換します。

Google Stitchを選ぶ理由

- 迅速なデザイン転換 – 自然言語やスケッチを使用して、数分で複数のUIレイアウトを生成できます([hdcourse.com][3])。

- 2つのAIモード利用可能 – 高速で高レベルのデザインのための「Flash」モード(月350回無料利用)と、詳細な画像ベースのプロトタイピングのための「Experimental」モード(月50回利用)

- 完全なコードエクスポート – プロダクションレディのHTML/CSSをダウンロードするか、Figmaに直接コピーしてさらにデザインを洗練させることができます

- Gemini AIを使用 – Gemini 2.5 FlashおよびProモデルを搭載し、信頼性の高いマルチモーダル性能を提供します

- インストール不要 – Google Labsでホストされた完全なブラウザベースのツールで、セットアップは不要です

コア機能

- テキストからUIへ: 「現代的なフィットネスアプリのインターフェースを作成」などの指示を入力すると、数秒でレスポンシブデザインのオプションが得られます

- スケッチ/画像からUIへ: ワイヤーフレーム、スケッチ、またはスクリーンショットをアップロード;Stitchはレイアウト要素を認識し、UIを生成します

- 多様なデザイン: 比較して選択するためのいくつかのレイアウトバージョンを受け取ります

- Figma&コードへのエクスポート: Figmaにワンクリックで貼り付けるか、実装用のHTML/CSSをエクスポートします

- インタラクティブなイテレーション: チャットまたはプロンプトベースの調整を通じてUIを洗練させ、リアルタイムプレビューを行います

Google Stitchの使い始め方

- stitch.withgoogle.comにアクセスし、Googleアカウントでサインインします。

- Standard Mode(Flash)またはExperimental Mode(Pro)を選択します。

- テキストプロンプトを入力するか、画像/スケッチをアップロードします。

- レイアウトタイプ(モバイル/ウェブ)とテーマの設定を選択します。

- デザインを生成し、バリアントを確認し、カスタマイズします。

- Figmaにエクスポートするか、HTML/CSSコードを直接取得します。

ヒント&トリック

- 具体的に記述する: レイアウト、スタイル、機能をプロンプトに含めます。例:「ヘッダーとグリッドメニューがある青を基調とした予約アプリのホームページ」

- ビジュアルモードを使用: Standardモードではテーマを調整できます;Experimentalモードでは視覚的な入力を処理して洗練された結果を得られます

- スケッチ+テキストを組み合わせる: 明確なプロンプトとともにワイヤーフレームをアップロードすると、最高の精度が得られます

- 迅速にイテレート: 両方のモードとプロンプトのバリエーションを試して、構造的なオプションを探ります

よくある質問(FAQ)

Q: Google Stitchはライブでアクセス可能ですか?

A: はい。StitchはGoogle Labsの一部で、Googleアカウントを使用してブラウザログインで今すぐ利用できます

Q: Stitchは何を作るのに役立ちますか?

A: スクラッチまたは画像からウェブ/モバイルUIをデザインし、複数のバージョンを生成し、Figmaにエクスポートし、すぐに使用できるHTML/CSSコードを生成できます

Q: Stitchは無料で利用できますか?

A: はい。寛大な無料ティアを提供しています:月350回のFlashモード実行と50回のExperimentalモード実行。一部の高度な機能は制限される場合があります

Q: StitchはFigmaのMake UIやUizardとどう違いますか?

A: Stitchはネイティブのプロンプト/画像からコードへのワークフローに優れており、直接コードエクスポートとFigma統合を提供します。Figmaは手動デザインに適しており、Uizardは視覚的なプロトタイピングに焦点を当てています

Q: Stitchはいつ発表され、リリースされましたか?

A: Stitchは2025年5月20日のGoogle I/O 2025で発表され、その後すぐにGoogle Labsを通じて利用可能になりました

関連サイト

コメント

コメントを投稿

あなたの考えを共有してください。* の付いた項目は必須です。